随着人工智能技术的快速发展,大模型已成为推动行业数字化转型的核心引擎。然而,大模型的训练与推理对算力、数据、平台支撑能力提出了极高的要求。因此,在大模型时代,企业如何高效利用算力资源、快速迭代模型并实现智能化应用落地,成为数字化转型的关键挑战。

谐云基于领先的云原生技术、深厚的算法模型积累和丰富落地经验,通过异构算力统一管理、资源池化、智能调度与训推一体化等核心技术,为企业提供从算力优化到模型落地的全面大模型支撑能力,助力企业在大模型时代实现技术突破与业务增长。

谐云大模型支撑能力优势概览

1、异构算力管理:高效管理,弹性扩展

据统计,截至2024年6月,我国算力规模已达246EFLOPS,智算领域同比增速超过65%。然而,算力资源的供需矛盾日益突出,尤其是面向人工智能和高性能计算的高端算力缺口巨大,算力资源的异构化特点也愈发显著。

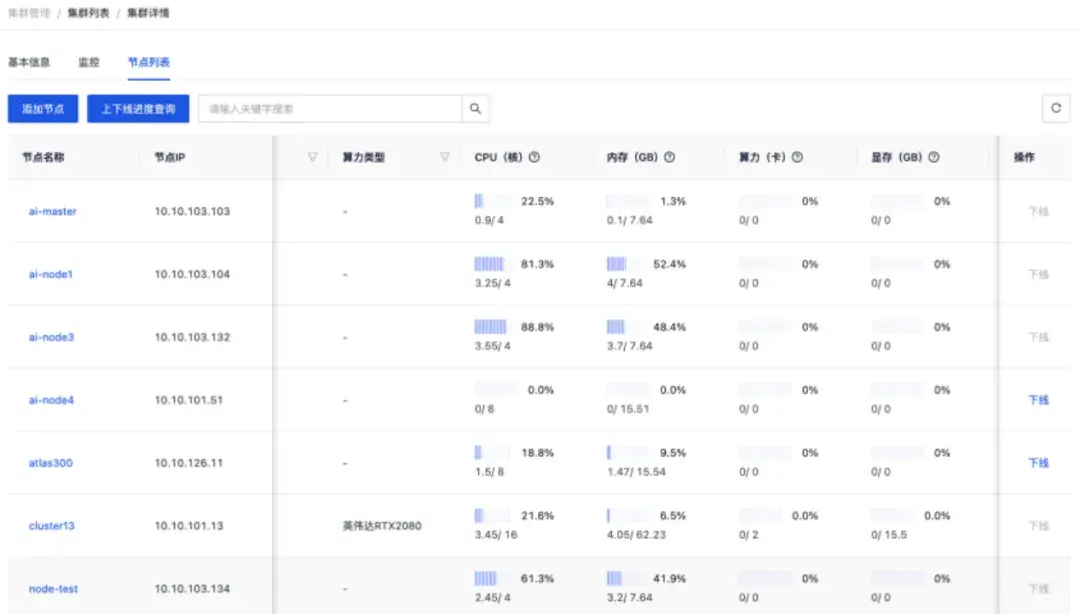

谐云基于kubernetes框架以多集群方式管理计算资源,实现计算资源集中式管理。旗下异构算力管理平台通过资源池化技术,将分散的CPU、GPU、FPGA等异构算力资源整合为统一的资源池,支持按需分配与弹性扩展。实现异构甚至异地的AI、HPC等不同算力资源的管理与运营能力。且能快速适配国内外主流厂商的加速芯片,统一智能算力资源的分配与调度。

异构算力统一管理满足对外运营,可以像使用水电一样方便的使用算力中心的各种算力资源,实现计费计量;实现多租户的数据、资源隔离,满足用户可根据业务需求选择算力进行作业提交。

无论是通用计算、智算还是超算场景,谐云都能提供灵活的资源分配策略,最大化资源利用率,降低算力成本。

2、大模型微调:快速迭代,精准优化

DeepSeek、Qwen、LLama等通用模型在各类NLP任务中展现出强大的性能,然而,通用大模型在训练时学习了大量各行各业通用知识,但缺乏针对行业领域的专业化训练,导致模型在处理特定行业特定场景的问题和任务时可能出现性能不佳、效率低下等问题。

微调是指在大模型的基础上,针对特定行业特定场景进行小幅度的参数调整。通过微调,可以让模型更好地适应特定任务的数据分布,从而提高模型的性能和准确率。

谐云提供高效的大模型微调能力,支持企业根据自身业务场景快速优化模型。通过数据预处理、模型训练到微调优化的全流程支持,帮助企业降低模型训练成本,提升模型性能,实现从通用模型到行业专属模型的精准适配。

包括支持可视化快速创建大模型微调任务,避免繁琐的环境配置;提供多机多卡的模型微调能力,实现大规模数据场景下的模型微调提速;通过历史数据预测和